GTC 2025 개발자 컨퍼런스에서 엔비디아는 AI 성능 향상에 초점을 맞춘 차세대 하드웨어 및 소프트웨어 시리즈를 소개했다.

엔비디아의 연례 GTC(GPU 기술 컨퍼런스) 컨퍼런스는 미국 캘리포니아주 산호세에서 열렸다. 올해는 3월 17일부터 21일까지 진행되었으며, 3월 18일에는 젠슨 황 CEO가 기조연설을 통해 엔비디아의 새로운 주력 제품을 소개했다.

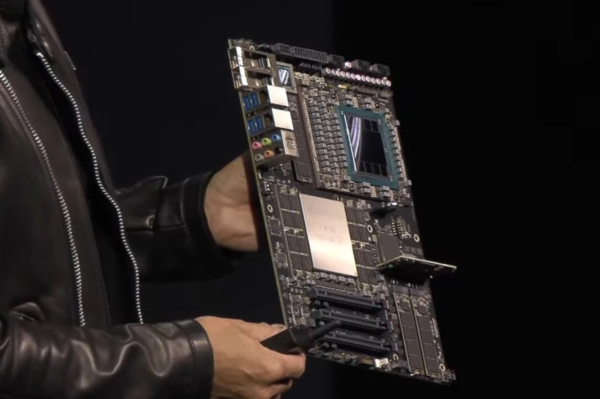

GPU 블랙웰 울트라 GB300

올해 말 출시될 예정인 블랙웰 울트라 GB300은 2024년 블랙웰 버전에서 업그레이드된 AI 그래픽 칩이다. 이 GPU는 여전히 '시니어'와 동일한 20페타플롭스의 AI 컴퓨팅 성능을 유지하지만, HBM3e 메모리는 192GB에서 288GB로 업그레이드했다. 2022년에 출시된 H100 모델과 비교하면 블랙웰 울트라는 AI 추론 능력이 1.5배 더 뛰어나며, 3년 전 출시된 칩 모델보다 초당 1,000개의 토큰을 처리할 수 있는 성능을 갖추고 있다.

"AI는 많은 발전을 이루었다. AI 추론 및 AI 에이전트는 기하급수적으로 높은 계산 성능을 요구한다."라고 황은 말한다. "우리는 이를 해결하기 위해 블랙웰 울트라를 설계했다. 이 플랫폼은 사전 학습, 사후 학습 및 추론 AI를 최고 수준으로 수행할 수 있는 유일한 범용 플랫폼이다."

엔비디아는 72개의 블랙웰 울트라 GPU와 36개의 엔비디아 그레이스 CPU로 구성된 새로운 칩을 클러스터로 판매할 예정이며, 이 칩은 "선도 클라우드에서 엔드 투 엔드로 완벽하게 관리되어 AI 작업을 위한 소프트웨어, 서비스 및 전문 지식으로 성능을 최적화한다"는 점에서 엔비디아 DGX 클라우드 프라이빗 클라우드 플랫폼에 연결할 수 있다

엔비디아는 또한 B300 NVL16이라는 더 작은 시스템을 제공한다. 이전 세대의 호퍼에 비해 칩 세트는 대형 언어 모델에 대한 추론 속도가 11배, 컴퓨팅 성능이 7배, 메모리가 4배 더 빠르다.

엔비디아에 따르면 블랙웰 울트라를 주문한 파트너로는 Cisco, Dell, HP, Lenovo, Supermicro 등이 있다. 회사는 제품 가격을 발표하지 않았다.

"슈퍼 칩" 베라 루빈

베라 루빈은 엔비디아의 다음 AI 칩 아키텍처이며, 황은 2026년에 출시될 예정이고, 루빈 울트라는 2027년에 출시될 수 있다고 말했다.

발표에 따르면, 베라 루빈은 최대 50페타플롭의 성능을 달성할 것이고, 루빈 울트라는 두 개의 베라 루빈 모델을 결합해 100페타플롭의 성능을 달성한다. 각 루빈 프로세서가 두 개의 GPU를 결합해 단일 칩을 형성하는 반면, 루빈 울트라는 네 개의 GPU를 결합한다. 이러한 시스템은 "AI 추론을 다음 단계로 끌어올리는 데 도움이 된다"는 데 강조되어 있다.

루빈 울트라 NVL576 클러스터는 블랙웰 울트라 클러스터보다 14배 더 높은 성능을 제공한다. 엔비디아에 따르면, 베라 루빈 NVL576은 카이버 랙이라는 새로운 액체 냉각 서버 랙 디자인에 들어갈 예정이다.

베라 루빈 아키텍처에 이어, 니브디아는 2028년에 출시될 것으로 예상되는 파인만이라는 새로운 아키텍처도 고려했다. 하지만 회사는 이 새로운 아키텍처에 대한 세부 정보를 발표하지 않았다.

AI DGX 개인용 컴퓨터

DGX에는 엔비디아가 "데스크톱 슈퍼컴퓨터"로 출시한 DGX Spark와 DGX Station의 두 가지 버전이 포함된다. 이 제품은 개발자가 대규모 시스템이 필요 없이 집에서 대규모 AI 추론 모델을 직접 실행할 수 있도록 지원하도록 설계된 블랙웰 울트라(Blackwell Ultra) 칩에서 실행된다. 로이터에 따르면 이는 PC 제품, 특히 애플의 하이엔드 맥에 대한 직접적인 도전으로 간주된다.

DGX 스파크는 초당 최대 1조 번의 연산을 수행하며, 엔비디아 코스모스 리즌 물리 AI 애플리케이션 모델과 엔비디아 GR00T N1 로보틱스 플랫폼 모델을 포함한 최신 AI 추론 모델을 통해 AI 튜닝 및 추론을 지원한다.

784GB의 대용량 메모리를 갖춘 더 강력한 DGX 스테이션은 대규모 학습 및 추론 워크로드를 가속화한다. ConnectX-8 SuperNIC 플랫폼은 하이퍼스케일 AI 컴퓨팅 워크로드를 가속화하도록 최적화되어 있다. 최대 800Gb/s의 네트워크 지원을 제공하는 ConnectX-8 SuperNIC은 여러 DGX 스테이션의 초고속 및 효율적인 네트워킹을 통해 추론을 가속화할 수 있다.

DGX 스파크와 DGX 스테이션은 Asus, Boxx, Dell, HP, Lambda, Supermicro에서 제조하며 올해 말 선주문 및 배송이 가능하지만 가격은 발표되지 않았다.

Spectrum-X 및 Quantum-X 실리콘 광자 네트워킹 칩

엔비디아의 새로운 실리콘 광자 네트워킹 칩 쌍은 데이터 센터와 같은 "AI 팩토리"가 여러 위치에 걸쳐 수백만 개의 GPU를 연결하고 전력 소비를 획기적으로 줄일 수 있도록 한다. Spectrum-X는 기존 이더넷에 비해 AI 네트워킹 성능을 1.6배 가속화하는 반면 Quantum-X는 대규모 AI를 위해 설계된 세계 최초의 엔드투엔드 고성능 800Gb/s 네트워킹 칩이다.

Quantum-X 칩. 사진: Nvidia

Spectrum-4 이더넷 스위치와 BlueField-3 SuperNIC를 사용하는 새로운 칩은 AI, 머신 러닝, 자연어 처리 및 광범위한 산업용 애플리케이션에 가장 높은 성능을 제공한다고 Nvidia는 말합니다. Quantum-X는 올해 말에 출시될 예정이며 Spectrum-X는 2026년에 출시될 예정입니다.

엔비디아 Dynamo는 분산 환경에서 생성 AI 모델을 제공하기 위한 오픈 소스, 저지연 모듈식 추론 플랫폼이다. 이 소프트웨어는 대규모 GPU 추론 워크로드를 원활하게 확장하는 동시에 지능적으로 라우팅하고 메모리 관리를 최적화하며 데이터를 원활하게 스트리밍한다. 목표는 AI 모델이 단일 답변을 내놓는 것이 아니라 여러 단계로 질문에 답하기 위해 "생각"하는 추론 프로세스를 가속화하는 것이다.

Dynamo는 DeepSeek의 DeepSeek-R1 또는 Meta의 Llama를 포함한 모든 인기 있는 대규모 언어 모델(LLM) 추론 및 최적화 AI 플랫폼을 지원한다. 해당 소프트웨어는 무료로 제공된다.

엔비디아 아이작 GR00T N1

GR00T N1은 엔비디아가 휴머노이드 로봇을 위해 설계한 모델로, "세계 최초의 개방형 휴머노이드 로봇 플랫폼"이라고 불린다. 이 모델은 로봇이 빠르고 느리게 사고할 수 있는 "듀얼" 시스템을 갖추고 있으며, 이는 추론 AI 모델과 매우 유사한 요소다. 여기서 "시스템 1"은 인간의 반사나 직관을 반영한 빠른 사고 행동 모델이고, "시스템 2"는 신중하고 체계적인 결정을 내리는 느린 사고 모델이다.

GR00T N1의 "골격"은 구글 딥마인드와 디즈니 리서치와 함께 개발한 오픈 소스 물리 엔진인 뉴턴이다. 이 엔진은 로봇 공학을 위해 만들어졌다. 한 손 또는 양손으로 물체를 잡고, 이동하고, 한 손에서 다른 손으로 물체를 옮기는 등의 일반적인 작업을 쉽게 일반화하거나, 긴 컨텍스트가 필요한 다단계 작업을 수행하고 재료 취급, 포장, 검사와 같은 일반적인 기술을 결합할 수 있다.

휴머노이드 로봇 개발자 중 GR00T N1을 조기에 이용할 수 있는 기업으로는 애자일 로보틱스, 보스턴 다이내믹스, 멘티 로보틱스, 뉴라 로보틱스 등이 있습니다. 아이작 GR00T N1은 올해 말에 발표될 예정이다.